來自IDC的報告顯示,2011年,1800EB的數據被創建和拷貝,且數據年增長率達到60%。如果將所有的數據都存儲在CD光盤上,堆起來的高度是地球到月球距離的6倍。另外,隨著各種家庭數字終端的興起以及Web2.0的廣泛應用,大眾成為信息創造的主體。移動互聯網把信息的生產從PC拓展到手機,物聯網把信息的生產從人拓展到物,IDC預測2020年全球產生的信息將達到350億TB。這些數據中的絕大部分將存儲在世界各地的大型數據中心。圖靈獎獲得者JimGray曾斷言,現在每18個月新增的數據量等于有史以來的數據量之和。信息數字化所產生的呈指數級增長的數據對存儲系統的容量提出了嚴峻的挑戰。

磁盤驅動器是一種機電混合設備。計算相比,存儲系統具有很多不同的特性。隨著社會信息化程度的不斷提高,對數據存儲的急劇提升,導致了以“計算”為中心到以“數據存儲”為中心的觀念革新。在過去的十多年中,磁盤的區域密度、軌密度和線密度分別獲得了100%、50%和30%的增長[4]。在存儲領域有兩個重要的技術對存儲系統的發展和存儲容量的擴展產生了重要的影響。第一個是并行存儲,比如磁盤陣列技術[5];第二個就是網絡技術對存儲系統體系結構的影響。通過將網絡引入存儲系統,改變主機與外部存儲節點間的連接模式,出現了若干新型存儲體系結構:附網存儲(NAS)和存儲區域網(SAN)。網絡存儲技術對于解決存儲設備的分散性、I/O的并行性、協議的高效性提供了一種很好的手段。網絡與存儲設備不同的結合方式可以形成不同拓撲結構的網絡存儲系統,不同的拓撲結構對于系統性能的影響也各不相同。但由于性能、價格、可擴展性等各方面的原因,這些仍不足以應對爆炸性的數據增長。另外,許多大型企業的IT基礎設施的利用率只有35%。在某些企業中可能會低至15%。Google報告稱其服務器的利用率往往在10%到15%之間[9]。這使得工業界不得不重新思考所面臨的問題,并努力尋求解決的方法。

2001年,Google在搜索引擎大會上首次提出云計算的概念。2007年年底,Google的一名工程師再次提出了云計算。自此,云計算開始得到工業界、學術界和各國政府的廣泛響應。嚴格意義上講,云計算并不是一種新技術,而是一種新的服務模式。云計算將應用和計算機資源包括硬件和系統軟件虛擬化之后包裝成服務,通過按需付費的方式,穿越Internet來滿足用戶各種不同的需求。用戶可以不再需要購買昂貴的計算機系統,不再因為需要短時間使用某個軟件而不得不購買該軟件的使用版權。這種服務模式在過去的十多年中有過充分的探討,這兩年的重新興起并以一個新的技術名詞出現,并不是因為產生了某種技術上的突破,而是由于信息數字化導致數據的爆炸性增長所帶來的一系列問題讓我們不得不重新思考計算機系統發展的新走向。另外,由于技術進步所帶來的部分老技術的重新復蘇也對云計算的發展起到了推波助瀾的作用。借助于云計算的理念,將存儲資源進行整合,并實現存儲資源的按需分配。于是就產生了云存儲。

1 云存儲面臨的挑戰

云存儲面向個人的應用主要由網盤、在線文檔編輯、工作流及日程安排;面向企業的應用主要有企業空間的租賃服務,企業級數據備份和歸檔、視頻監控系統等。無論是哪種應用,海量數據的高度聚集都要導致存儲系統從少數的存儲引擎向連在網絡上的成千上萬的商用化存儲設備進行轉變,從傳統的煙囪式的建設模式轉變為集約化的建設模式。在過去的十多年中集群網絡的重要進展之一是可以將成千上萬的節點連起來,同時保證高可擴展性和相對較低的通信開銷。因此,我們認為,采用商用化的技術來構造可擴展的集群是云存儲的基本組件。因為我們可以以搭積木的形式來聚合存儲組件以構造大規模的存儲系統。但是現有的存儲系統進行規模的擴展之后還存在很多待解決的問題。

1.1 名字空間

存儲器空間的組織和分配,數據的存儲、保護和檢索都依賴于文件系統。文件系統由文件和目錄組成。數據按其內容、結構和用途命名成不同的文件,而目錄則構建文件系統的層次化結構。現代的文件系統一般都是按樹形的層次架構來組織文件和目錄。集群文件系統往往也采用樹形架構來構造名字空間。然而,當數據的訪問從樹根走向樹葉的時候,訪問的延遲會相應地增加。另外,還有兩個重要的因素導致樹形架構不適合于云存儲環境。第一,樹根本身就是一個單一失效點,而且很容易形成系統的“瓶頸”;第二,樹形架構很難在Internet上擴展到地理上分布的規模。另外,層次化結構使得文件的訪問效率不高。每一層目錄都隱藏了它所包含的子目錄和文件,用戶很難知道一個目錄下面到底有哪些文件和子目錄。因此,用戶訪問某個文件時,必須通過層次型的目錄樹結構到達其保存位置,如果不知道文件保存位置,則必須遍歷整個目錄。因此云存儲只有采用非集中式的名字空間來避免潛在的性能“瓶頸”和單點失效。

1.2 元數據組織

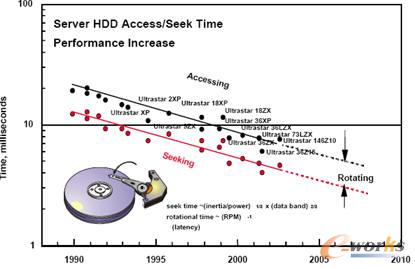

元數據是描述數據的數據,主要用來反映地址信息和控制信息,通常包括文件名、文件大小、時間戳、文件屬性等等。元數據主要是用來管理的操作數據。研究表明,在文件系統的操作中,超過50%的操作是針對元數據的[10]。元數據最重要的特點是其往往是小的隨機請求。一般來講,元數據都是存儲在磁盤上的,然而,和磁盤存儲容量的增長不同的是,由于機械組件所帶來的延遲,磁盤的平均訪問時間每年的降低不足8%。Hitachi的磁盤在過去10年里磁盤訪問時間和尋道時間的發展趨勢[12]如圖1所示。對于這種由小的隨機請求所組成的數據訪問流,磁盤的尋道時間是磁盤訪問延遲中最主要的部分。因此,對于大規模系統來講,元數據的訪問往往成為制約整個系統性能的“瓶頸”。

圖1 磁盤訪問時間和尋道時間的發展趨勢

很多分布式的存儲系統將數據訪問和元數據的訪問分離開來。在這樣的系統中,客戶端首先和元數據服務器通信來獲取元數據包括文件名、文件位置等信息。然后,利用該元數據,客戶端直接和數據服務器通信去訪問相應的數據。一般來講,元數據服務器的內存可以滿足大部分的讀請求,但服務器不得不周期性地訪問磁盤來讀取需要的數據,并且所有元數據的更新也要寫回到磁盤。存儲系統空間的增長可以通過增加額外的存儲服務器來保證。然而,對于一個管理數以億計的數據文件的云存儲系統,保證元數據的訪問性能和可擴展性比較困難。對于像云這樣的需要高可擴展性的環境,對元數據的依賴給系統設計帶來了巨大的挑戰。

1.3 能耗與地板空間

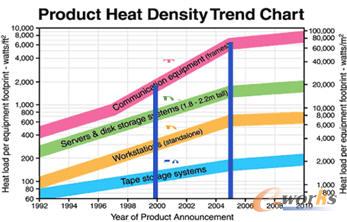

圖2 數據中心的熱密度趨勢圖

2005年美國新建立的數據中心需要消耗的能量相當于加利福尼亞州所消耗能量的10%(大約5GW),需要花費大約40億美金。英國的1500個數據中心每年消耗的能量和英國第十大城市萊卡斯特所需要的能量相當。2010年,英國單個數據中心每年在能量上的花費達到大約740萬英鎊。在這些數據中心中,存儲系統所消耗的能量達到了總能耗的27%。另外,消耗的能量除了供各種計算機組件工作外,還會產生大量的熱量。由于大部分計算機組件只能在一定的溫度環境下才能保證足夠的可靠性,因此,還需要額外的能量驅動制冷設備。Netapp的調查表明大型數據中心中制冷系統的能耗僅次于服務器。數據中心主要設備的熱密度趨勢如圖2所示。可以認為,數據中心的能耗問題處于一個惡性循環的狀態。

另外,由于數據的增長導致數據中心對新設備需求的不斷增加,但是數據中心的可擴展性完全受限于其地板空間。在數據中心的空間未擴展的情況下,隨著單位地板面積內計算機設備的不斷增加,傳統數據中心的設備容量必將達到極限。因此,能耗和地板空間成為當前設計和管理大型數據中心所面臨的主要挑戰。

2 云災備

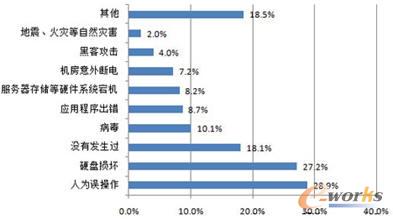

圖3 數據丟失的原因

國際上對于IT系統災難的定義是指由于人為或自然的原因,造成信息系統運行嚴重故障或癱瘓,使信息系統支持的業務功能停頓或服務水平不可接受,并達到特定的時間的突發性事件。雖然數據是企業的命脈,然而在傳統的存儲系統下,數據丟失很難避免。數據丟失的原因如圖3所示。圖3表示人為因素是導致數據丟失的最重要的原因。由于管理員或員工的活動造成數據的損失或變更,使數據的完整性與真實性受到影響,如誤刪除、誤格式化或誤分區、誤克隆等誤操作,系統管理員出錯或蓄意破壞、竊取等等。因此,如果在云計算環境下,專業的工程技術人員將能最大限度地避免由于人為因素所導致的數據丟失。然而,設備和硬件故障所帶來的數據丟失則很難避免。例如,硬盤損壞是極為常見的導致數據丟失的原因,一般來講,磁盤陣列(RAID)系統能夠一定程度上避免硬盤故障導致的數據丟失,如RAID1、RAID5都能夠在一塊硬盤失效后對數據進行修復。但在兩塊硬盤失效的情況下,則僅有RAID6數據保護模式能夠保護數據不丟失,而RAID6由于復雜冗余和校驗算法導致系統大量的開銷,一般企業采用時存在顧慮。另外,大型存儲系統中磁盤的失效往往是具有相關性的,一塊大容量磁盤失效后要進行長時間的重構(例如,1TB容量的磁盤重構可能需要數小時),會對系統帶來極高的存儲I/O率,這可能導致另一塊磁盤的失效,從而引發連鎖效應。因此,利用蝴蝶效應來描述毫不為過。

2011年4月,亞馬遜的網絡服務經歷了長時間斷電,造成停機等一系列問題,并且影響到了云計算的服務。在長達4天的時間里,一些客戶無法使用亞馬遜的存儲服務,并且會出現網絡配置錯誤。2011年4月25日,Vmware的Cloud Foundry在發布13天后連續兩天發生服務中斷事件。第一次是由于某供電柜發生故障,在停機持續了10小時后,故障得到修復。但在第二天,當Vmware的官方工作人員在嘗試實施先期檢測方案以避免前一天的事故再一次發生時,導致了新一輪的停機。2011年8月,都柏林的亞馬遜和微軟的數據中心因遭遇雷擊而停電,兩家企業都經歷了數天才完成修復。國際最知名的IT企業也無法保證其IT基礎設施的24×7×365業務連續性。再者,不可預測的自然災害也會導致數據丟失,如日本的廣島地震,中國的汶川地震等。因此,對數據進行有效的災備,并經常性的進行恢復演練確保備份的有效性能夠最大程度的降低因為硬件故障導致數據丟失的可能性,充分得到云存儲用戶的信任。

2.1 災備的技術指標

在容災體系中,人們往往采用恢復點目標(RPO)和恢復時間目標(RTO)這兩個指標來衡量容災體系的應急能力和系統保護能力。RPO體現為災難發生后,恢復運轉時數據丟失的可容忍程度。RTO表示需要恢復的緊迫性也即多久能夠得到恢復的問題。然而,在設計一個容災系統時,并不意味著RPO和RTO越小越好。因為系統投資會隨著RPO和RTO的降低而增加。因此,最佳的容災方案不一定是性價比最好的方案。

2.2 數據備份

數據備份是指為防止系統出現操作失誤或系統故障導致數據丟失,而將數據集合從應用系統中以備份格式存儲到處于離線的存儲介質的過程。在數據備份過程中,一般采用備份軟件配合磁帶庫的物理介質保存系統來進行。數據備份分為完全備份、差異備份和增量備份。完全備份是指對某一個時間點上的所有數據或應用進行的一個完全拷貝。差異備份則備份自上一次完全備份之后有變化的數據。增量備份則備份自上一次備份(包含完全備份、差異備份、增量備份)之后有變化的數據。無論哪種模式都完全服從備份計劃的規定,即在固定的時間點開始備份。

傳統的備份系統并不保證數據的實時性或近實時性。而且,備份后的數據格式是專用的備份格式,并非應用系統中的數據原有格局。因此,當發生災難時,備份數據是不能立即使用的,必須先恢復。恢復時要通過格式轉換進行導回操作,這導致無法保證恢復的快捷。例如,如果按Th的時間間隔來進行增量備份。如果在A時間點發生了系統故障,那只能回復到上一個備份點A-T,而且還要進行數據格式的轉換。隨著T的增加和數據量的增漲,需要恢復的時間也隨之線性增漲。因此,指標RPO和RTO都會較高,也很難保證IT基礎設施的24×7×365業務連續性。另外,為了提高RPO,必須提高數據備份的頻度。但大多數情況下,僅僅增加備份的頻度會帶來一系列的問題。例如:應用的高峰時段無法進行備份操作;備份數據所花時間太長。因此,需要有一個契機和一個新的技術的誕生,來達到以用戶為中心的數據安全和系統安全的要求。

核心關注:拓步ERP系統平臺是覆蓋了眾多的業務領域、行業應用,蘊涵了豐富的ERP管理思想,集成了ERP軟件業務管理理念,功能涉及供應鏈、成本、制造、CRM、HR等眾多業務領域的管理,全面涵蓋了企業關注ERP管理系統的核心領域,是眾多中小企業信息化建設首選的ERP管理軟件信賴品牌。

轉載請注明出處:拓步ERP資訊網http://m.guhuozai8.cn/

本文標題:云存儲與云災備的原理與短板分析(上)

本文網址:http://m.guhuozai8.cn/html/consultation/1083978019.html